I predittori della performance accademica: le prove di ammissione le procedure e i risultati

I predittori della performance accademica: le prove di ammissione le procedure e i risultati

Le procedure

Lo strumento utilizzato ai fini della selezione fu composto da 50 item a scelta multipla.

Gli item, bilanciati per aree tematiche, furono posti secondo un ordine fisso di sequenza.

Tutti i partecipanti vennero invitati a contrassegnare, nell’apposito foglio, le risposte esatte, avendo l’accortezza di non tralasciare alcuna domanda, pena l’esclusione dalla prova di selezione.

Per il completamento della prova furono assegnati 30 minuti.

Il calcolo dei punteggi consistette nell’attribuire il valore di 1,5 punti ad ogni risposta esatta e 0 punti ad ogni risposta sbagliata.

In caso di risposte doppie o di contrassegni ambigui venne assegnato un punteggio pari a zero.

Non sono state utilizzate formule correttive per la penalizzazione delle risposte sbagliate o per le risposte indovinate a caso.

I risultati

I dati presentati in seguito, sintetizzano i risultati ottenuti nel corso di una sperimentazione triennale (1993-1996) effettuata mediante postume indagini empiriche. Le indagini sono state svolte al fine di accertare la validità e le caratteristiche psicometriche degli strumenti utilizzati a fini selettivi. Tenendo conto dei risultati sino a quel momento ottenuti, ogni anno ciascun test è stato costruito ex novo e ha presentato caratteristiche del tutto peculiari. Pur non potendo assumere una stretta equivalenza metrica degli strumenti, vi sono tuttavia diversi elementi che lasciano presupporre una sostanziale concordanza delle prove: la condivisione dei criteri adottati, il richiamo costante alle aree di contenuto ed una continuità temporale assicurata dalla stabilità della commissione che ha messo a punto i questionari.

L’uso di prove di ammissione all’Università non sufficientemente validate sul piano empirico o scarsamente corroborate dai risultati della ricerca sperimentale, suscita sempre una comprensibile e legittima perplessità (Amoretti, Baldi, Piazzini, Spairani, 1993; Arcuri, Soresi, 1997; Legrenzi, 1994; Legrenzi e Rumiati, 1995). È tuttavia doveroso sottolineare che, nel caso le prove assumano finalità selettive, la loro validazione è, nella migliore delle ipotesi, di tipo retrospettivo e spesso necessariamente limitata.

Sperimentare un test di selezione per l’ammissione all’Università su un campione rappresentativo della popolazione bersaglio, significherebbe, con buona probabilità, rendere anzitempo disponibili le domande e correre, quindi, il rischio di una sicura ‘invalidazione’ di tipo giudiziario. A selezione avvenuta, è molto difficile che coloro che non sono risultati ammessi si sottopongano, a distanza di tempo, ad una seconda prova, predisposta al fine di verificare la accuratezza degli strumenti. Sarebbe come chiedere ad una persona scampata ad una fucilazione se si pu adagiare gentilmente per terra affinché si possa verificare se il fucile spara con precisione (Guicciardi e Lostia, 1998).

Occorre anche tenere presente che il contesto non più selettivo ma simulativo di una selezione, modificherebbe le motivazioni, gli stili di risposta e l’interesse per la riuscita, con inevitabili ripercussioni sulla distribuzione dei punteggi.

Per verificare l’attendibilità degli strumenti, gli autori hanno fatto ricorso al computo dell’alfa di Cronbach (1984), istituendo una sorta di confronto tra il questionario utilizzato ed un suo equivalente virtuale (Nunnally e Bernstein, 1994).

La mediana dei coefficienti alfa è risultata pari a .55, un valore decisamente basso che, sebbene rappresenti una stima conservatrice dell’attendibilità delle misure (Rubini, 1984), non pu essere considerato accettabile in base agli standard riportati in letteratura (Rubini, 1975; Nunnally e Bernstein, 1994).

Buona parte della varianza dei punteggi al test di ammissione sembra, infatti, dipendere da una pronunciata incidenza di errori casuali, in parte riconducibile alla procedura utilizzata, in parte dovuta all’impiego di un numero limitato e probabilmente insufficiente di domande, che all’analisi degli item, presentano sostanziali variazioni nelle percentuali di riuscita (p-values) e che sono probabilmente eterogenei per contenuto e multidimensionali per struttura (per ottenere un valore accettabile di alfa (>.80) non sarebbe sufficiente triplicare il numero di item nell’ipotesi teorica che anche le nuove domande presentino le stesse proprietà metriche. Il valore p indica la probabilità che un soggetto qualsiasi, estratto casualmente dalla popolazione a cui appartiene il campione, fornisca la risposta esatta (alfa) alla domanda (Rubini, 1975). In genere gli item che manifestano una probabilità di risposta alfa prossima a .50, sono quelli che risultano maggiormente discriminanti a tutti i livelli della abilità misurata.

Mediante l’item analysis gli autori hanno potuto osservare che il 33% dei quesiti ha avuto una proporzione di risposte alfa inferiore a .20. Tale proporzione raddoppia se l’indice di difficoltà è corretto per le risposte date a caso, nell’ipotesi di una eguale attrattiva delle alternative).

Per poter dirimere questi dubbi, la struttura dei questionari è stata verificata a posteriori utilizzando l’analisi delle componenti principali (tutte le elaborazioni statistiche sono state condotte con le librerie di programmi per Windows SPSS e STATISTICA).

Usando come dati di partenza la matrice di correlazione tra i punteggi ottenuti da 636 candidati negli item del questionario, sulla base dello scree test di Cattell, gli autorihanno individuato tre componenti che spiegano il 17% della varianza complessiva. Prendendo in considerazione le saturazioni > .35 in valore assoluto, hanno identificato un fattore di Abilità di ragionamento e conoscenze matematiche (eigenvalue 2.63, % varianza spiegata 8.22), un fattore di Conoscenze di attualità e legislazione (eigenvalue 1.45,% varianza spiegata 4.54) e un fattore di Conoscenze letterarie (eigenvalue 1.35, % varianza spiegata 4.24) (al fine di rendere più evidente la struttura retrostante i dati, considerate le indicazioni provenienti dal calcolo dell’alfa di Cronbach e della correlazione media inter item che insieme depongono per una sostanziale disomogeneità del test (Dunteman, 1989; Nunnally e Bernstein, 1994), gli autori hanno ritenuto opportuno escludere dai calcoli successivi sia gli item che sono risultati molto difficili o molto facili (20% > risposte alfa > 80%) sia quelli che hanno presentato una bassa correlazione con il punteggio totale (< .10 in valore assoluto). L’utilizzo congiunto di entrambi i criteri, ha condotto all’esclusione di ben 18 item (36%). Sui punteggi dei rimanenti item è stata eseguita un’analisi delle componenti principali con rotazione degli assi secondo la procedura VARIMAX normalizzata).

Come si pu osservare nella Tabella 3.2, la sovrapposizione tra le aree di contenuto identificate a priori e le dimensioni principali, è molto parziale: solo la metà degli item satura, con un peso non irrilevante, le componenti estratte. Il fattore più consistente, il primo, che implica prevalentemente abilità di ragionamento, copre i contenuti di tre aree diverse (Letteratura, Matematica e Scienze). Il secondo fattore, in ordine di importanza, raggruppa conoscenze relative a diversi contenuti disciplinari con prevalenza per quelli storici e di attualità. Solo il terzo fattore identifica quasi esclusivamente l’area letteraria.

La modalità di formulazione dei quesiti sembra, pertanto, avere influito in modo molto limitato sul significato degli item, sollecitando abilità di ragionamento che intersecano e si sovrappongono allo specifico contenuto delle domande. La percentuale di varianza spiegata dalle combinazioni lineari dei punteggi è quanto mai esigua e ci suggerisce un’estrema cautela nell’interpretazione della struttura fattoriale. Le dimensioni individuate potrebbero infatti essere dovute più alla somiglianza delle distribuzioni degli item che alla condivisione di un significato

comune (Nunnally e Bernstein, 1994) (tale fenomeno si presenta spesso quando si sottopone ad analisi fattoriale la matrice di correlazione tra item piuttosto che i punteggi ottenuti nelle singole scale o nell’intero test. Un motivo pu essere rintracciato nella scarsa correlazione tra item e nel- l’esigua varianza dei coefficienti di correlazione, che risultano particolarmente evidenti se le domande ammettono due sole possibilità di risposta (del tipo: giusta o sbagliata). I coefficienti di correlazione sono nella maggior parte dei casi compresi tra valori r di .10 e 30 (Flores d’Arcais, 1968).

Al fine di disporre di ulteriori evidenze in merito al contenuto degli item e alla struttura delle prove, gli autori hanno, successivamente, somministrato ad un gruppo di N.103 ammessi, frequentanti il Corso di Psicologia Generale (1993-94), il Reattivo di Vocabolario Wide-Range (V.R. 8-55) di Remondino (1980) e il Test delle frasi in disordine di Goguelin (1952) (il Reattivo di vocabolario è un test di potenza che misura la comprensione di un ampio spettro di vocaboli. Nel Test delle frasi in disordine il riordinamento delle parole costituisce una pre-condizione per decidere se le asserzioni hanno un senso compiuto. La somministrazione di entrambi i reattivi è avvenuta collettivamente ed è stata eseguita dopo aver suddiviso il campione originario in due sottogruppi equipotenti. L’ordine di somministrazione dei test è stato controbilanciato in maniera inversa tra i gruppi) (matricole N. = 180. Di tutte le variabili prese in considerazione (es. sesso, voto di diploma, tipo di diploma, etc.), solo l’età è risultata discriminare il campione, che in media presenta valori inferiori (anni 21.1 vs. 23.6, z = –3.44, p < .001).

L’analisi dei coefficienti di correlazione prodotto-momento di Pearson, calcolati a partire dai punteggi standardizzati, ha permesso di osservare che la prova di ammissione correla positivamente ed in maniera significativa con i risultati di entrambi i test intellettivi (Tab. 3.3). In particolare, i fattori Abilità di ragionamento e Conoscenze di attualità e legislazione sono quelli che manifestano le correlazioni più elevate con il test di Goguelin. Viceversa, il voto di diploma sembra sintetizzare delle capacità affatto differenti dal momento che presenta correlazioni negative con tutte le altre variabili osservate ed in particolare con il punteggio totale del test di ammissione, con il fattore Conoscenze letterarie e con il test di Goguelin. Mentre le prime due correlazioni possono essere imputate a dei biases presenti nel campione, la relazione inversa, sia pure modesta, con il test di Goguelin (r = –.20), lascia aperto qualche interrogativo sulle competenze e abilità che il voto di diploma dovrebbe riassumere (poiché i dati si riferiscono ad un gruppo di matricole frequentanti e non alla totalità dei candidati, la correlazione tendenzialmente negativa tra VD-PE (r = –.44) pu essere dovuta al ruolo complementare che assumono tali variabili nel campione, selezionato proprio sulla base della somma dei contributi di entrambi i criteri. Viceversa, la relazione VD-III pu essere ipoteticamente attribuita ad un effetto spurio del tipo di diploma).

Le evidenze raccolte tramite l’analisi delle componenti principali e il calcolo dei coefficienti di correlazione, convergono nel sostenere l’ipotesi che la formulazione degli item (ad esempio, con doppia negazione) o il tipo di compito richiesto (ad esempio, individuare il significato opposto di un termine scientifico), abbiano, in realtà, influito sulla struttura delle domande e modificato il contenuto del questionario rendendolo un strumento che sollecita, oltre alle conoscenze di cultura generale, alcune competenze di base come l’abilità di ragionamento su contenuti semantici, sia di tipo verbale che numerico (Boncori, 1993).

Per saggiare la consistenza della struttura fattoriale precedentemente individuata, l’anno seguente è stata eseguita una analisi delle componenti principali partendo, questa volta, dai punteggi che i 767 candidati hanno totalizzato nelle cinque aree di contenuto.

Sulla base dello scree test di Cattell, sono emersi due fattori che insieme spiegano il 48% della varianza complessiva. Il primo fattore (28% di varianza spiegata) satura quasi tutte le aree di contenuto e sembra rappresentare un fattore generale di conoscenza, il secondo fattore (20% di varianza spiegata) satura prevalentemente l’area Matematica, fisica e geometria e sembra identificare una capacità di ragionamento prevalentemente di tipo numerico e verbale. L’introduzione in analisi del voto di diploma, non modifica sostanzialmente la struttura individuata mentre l’inclusione della variabile età, aumenta la percentuale di varianza spiegata (53%) e consente di discriminare in uno spazio tridimensionale: i) le conoscenze legate a fenomeni di attualità (eigenvalue 1.47, varianza spiegata 21%); ii) le conoscenze che implicano rapidità di calcolo o abilità di ragionamento simbolico (eigenvalue 1,24, varianza spiegata 18%); iii) le conoscenze scientifiche e le domande che si basano sul ragionamento verbale (eigenvalue 97, varianza spiegata14%).

Dalle analisi sinora effettuate emergono pertanto due indicazioni di estremo interesse:

1) i test tendono a misurare, oltre che elementi di cultura generale, alcune abilità di ragionamento che risultano trasversali rispetto alle singole aree di contenuto;

2) i test sono inflazionati dall’errore di misurazione imputabile in via ipotetica a: a) un’insufficiente campionatura degli item; b) un’elevata eterogeneità delle domande; c) un’eccessiva difficoltà delle prove; d) una procedura di scoring inaffidabile.

Date queste caratteristiche, gli autori si sono chiesti se le prove utilizzate fossero state adeguate all’obiettivo prefisso: selezionare i candidati che con una maggiore probabilità avrebbero maturato una buona preparazione in psicologia.

Il criterio adottato è di non immediata operazionalizzazione dato che, tanto più il criterio è ambiguo, sensibile a fattori irrilevanti o remoto, tanto più è difficile mettere a punto degli strumenti validi o effettuare delle predizioni accurate (Anastasi, 1976; Boncori, 1993).

Nel caso specifico, è apparso da subito improponibile il vincolare il criterio alla riuscita professionale, dal momento che esistono infinite attività che contraddistinguono la professione dello psicologo (Perussia, 1994).

L’assumere tout court come criterio la riuscita professionale, presenta alcuni aspetti paradossali: è lecito ipotizzare che le richieste rivolte alla professione dello psicologo muteranno nel tempo in virtù delle trasformazioni sociali, dello sviluppo tecnologico e delle forme che il disagio e il benessere assumeranno. Non è da sottovalutare, invece, il ruolo che le stesse conoscenze psicologiche potranno svolgere nel promuovere o nel sostenere tali cambiamenti. Essendo, inoltre, le competenze professionali, fondate sulle conoscenze acquisite durante il corso di studi, un test di ammissione che fosse in grado di predire accuratamente la futura riuscita professionale dei candidati metterebbe in risalto il fallimento dell’istituzione universitaria nello sviluppare proprio quelle conoscenze che dovrebbero sostenere le suddette competenze. Quest’ultimo aspetto ha suggerito di escludere dal questionario qualsiasi riferimento ai contenuti propri della psicologia prediligendo un criterio intermedio, la riuscita accademica. Questo criterio consente una verifica empirica tramite un indicatore parziale e di facile disponibilità come il rendimento negli esami del biennio (Boncori, 1993), valutabile sui piani di efficacia ed efficienza (Giossi, Bertani e Muzio, 1996).

La scelta di un test di conoscenze generali, pur con i suoi pregi e difetti (Boncori e Tanucci, s.d.; Arcuri e Soresi, 1997; Legrenzi e Rumiati, 1995), ha assunto l’obiettivo di accertare le informazioni di base degli studenti, cercando di non penalizzare eccessivamente quanti, per curriculum di studi, non disponevano di conoscenze pertinenti all’ambito psicologico. L’avere abolito, con il passare degli anni, le domande di stretto contenuto nozionistico, sostituendole con altrettante che ponevano in gioco alcune abilità di ragionamento, pu avere prodotto un’involontaria iniquità delle misure.

Gli autori si sono domandati se la padronanza delle abilità individuate dalla analisi delle componenti principali potesse avere discriminato in modo differenziale particolari gruppi di soggetti. Mediante una serie di analisi multivariate della varianza (MANOVAs), utilizzando i punteggi fattoriali come misure ripetute, è stato verificato se il sesso, il tipo di diploma e l’età possono avere costituito delle variabili discriminanti.

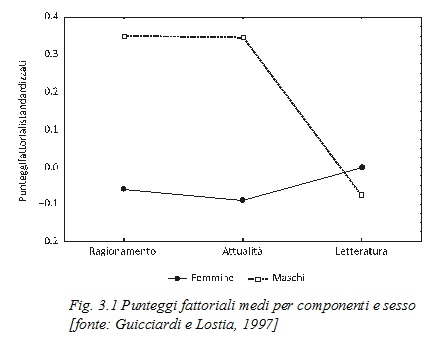

Il confronto maschi-femmine (fig. 3.1) ha evidenziato un’interazione altamente significativa (F2,1234 = 7.48, p < .0006): i maschi hanno ottenuto punteggi più elevati nei fattori Abilità di ragionamento e Conoscenze di attualità ma non sono emerse differenze significative nel fattore Conoscenze di letteratura.

Il confronto relativo ai tipi di diploma (fig. 3.2) ha mostrato un’interazione statisticamente significativa (F12,1224 = 4.45, p < .00001): chi in possesso di maturità liceale ha ottenuto un punteggio più elevato nei fattori Abilità di ragionamento e Conoscenze letterarie. Non sono emerse differenze significative tra i tipi di diploma, per ci che riguarda le Conoscenze di attualità, fattore che nell’analisi successiva ha, invece, mostrato una relazione lineare con l’età (F6,1230 = 12.89, p < .00001).

Le differenze riscontrate, seppure statisticamente significative, riguardano solo una parte modesta della varianza complessiva dei punteggi (17%). Esse possono avere inciso in maniera superficiale sulla graduatoria finale che è stata stilata sulla base del contributo fornito dal test

e dal voto di diploma e, solo a parità di punteggio totale, dall’apporto del fattore età, che ha privilegiato i candidati più giovani.

Le dimensioni individuate mediante l’analisi delle componenti principali nella loro complessiva articolazione, non sembrano avere avvantaggiato alcun gruppo di soggetti in particolare. Possono, piuttosto, avere riequilibrato le diseguaglianze di partenza strettamente dipendenti dal voto di diploma, che, come è noto, risulta mediamente più basso al Liceo, tra i maschi e tra i meno giovani (Guicciardi e Lostia, 1995; Guicciardi, 1996).

Gli autori hanno potuto osservare che, ancora una volta, il rapporto tra voto di diploma e punteggio al test di ammissione risulta quanto mai controverso: le analisi condotte sulla totalità dei candidati hanno sempre mostrato una debole correlazione lineare positiva (mediana dei coefficienti r = .19). Analoghi risultati sono stati riferiti in più occasioni da molti ricercatori (raccolte di readings curate da Perussia, Converso e Miglietta (1995) e da Giossi e Bertani (1997)).

A distanza di cinque anni, l’analisi è stata replicata su 147 matricole del corso di Psicologia Generale (anno accademico 1995-96). Durante l’esercitazione sono stati somministrati il Test delle frasi in disordine di Goguelin (1952), il Mach IV di Christie, nell’adattamento italiano di Galli e Nigro (1983) (la scala misura un tratto di personalità definito orientamento machiavellico, che corrisponde alla tendenza a manipolare gli altri nelle situazioni interpersonali) ed un test di ammissione in Psicologia messo a punto da una Commissione Nazionale di esperti ed utilizzato lo stesso anno dalle Università di Bologna, Firenze, Milano (Cattolica), Padova, Torino e Trieste (Guicciardi, 1996) (la versione utilizzata dagli autori, corrisponde al test V.A.’95 fornita dall’Università di Torino. Iltest si compone di due opuscoli (prova 1 e prova 2), per un totale di 110 domande di cui 90 relative ad abilità che richiedono un ragionamento di tipo verbale, astratto o numerico e 20 relative alla comprensione di brani).

Al fine di identificare eventuali ridondanze tra le misure prese in considerazione, è stata dapprima condotta una analisi delle componenti principali con rotazione degli assi, secondo la procedura Varimax normalizzata. L’analisi è stata estesa all’età, al voto di diploma e al punteggio ottenuto alla prova di ammissione di Cagliari.

Sulla base dello scree test di Cattell, sono state individuate due componenti che spiegano il 48% della varianza complessiva. La prima dimensione (eigenvalue 4.29; 36% di varianza spiegata) contrappone la prova 1-V.A. ’95 che raggruppa i sub-test di ragionamento verbale, simbolico e numerico alla variabile età e all’orientamento machiavellico. La seconda dimensione (eigenvalue 1.44; 12% di varianza spiegata) contrappone i punteggi del test di ammissione (Cagliari) e della prova 2-V.A. ’95 al voto di diploma.

I risultati ottenuti, pur in presenza di una rilevante percentuale di varianza non spiegata, autorizzano a ipotizzare che i due test di ammissione, quello nazionale e quello locale non siano tendenzialmente tra loro equivalenti, dal momento che saturano fattori diversi. Ne è riprova il fatto che, mentre la prova 1 del test nazionale manifesta una forte consistenza interna (alfa di Cronbach: omnibus = .94; mediana dei subtest = .74), il questionario di Cagliari risulta poco omogeneo e per molti aspetti più simile alla prova 2 del test V.A. ’95.

Di fronte a questa supposta differenza, gli autori si sono, infine, domandati quale delle due prove di ammissione potesse meglio predire la riuscita accademica, valutata secondo i parametri del numero di esami sostenuti e della votazione media in essi riportata. A tal scopo, hanno preso in considerazione i dati delle matricole relativi alla prima sessione utile di esami (sessione estiva 1996) (i dati sono stati messi a disposizione dal Centro Servizi Informatici di Ateneo (CSIA) e dalla Segreteria Amministrativa della ex Facoltà di Scienze della Formazione. Poiché non è prevista la semestralizzazione degli insegnamenti, la sessione estiva rappresenta, per le matricole, la prima occasione utile a poter sostenere gli esami relativi ai corsi sino ad allora frequentati).

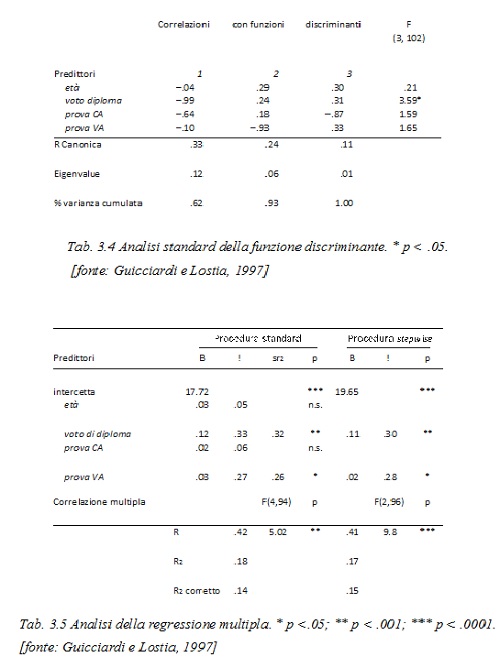

Assumendo come criterio il numero di esami sostenuti e come predittori l’età, il voto di diploma, il punteggio di ammissione (prova CA) e il punteggio al test nazionale (prova VA) mediante un’analisi standard della funzione discriminante multipla, gli autori hanno individuato i tre insiemi di variabili (‡ di Wilks = .84; X2 (12) = 19.1; p = .09) che consentono di discriminare le matricole sulla base del numero di esami sostenuti. Come si pu osservare nella tabella che riporta i coefficienti standardizzati (Tab. 3.4), la prima funzione discriminante (62% varianza comune spiegata) sottolinea il contributo del voto di diploma che risulta essere l’unico predittore statisticamente significativo (F3,102 = 3.59; p < .05), la seconda (31% varianza spiegata) evidenzia la capacità discriminativa del test nazionale e l’ultima (7% di varianza spiegata) premia la prova locale.

Ad una successiva analisi stepwise, condotta secondo la procedura forward, solo la prima funzione è risultata statisticamente significativa (X2 (9) = 18.6 p < .05). Essa ha messo in rilievo il potere discriminante del voto di diploma (p < .05) ed il contributo della prova locale e della prova nazionale.

L’utilizzo del criterio votazione media agli esami ha richiesto un ulteriore restringimento del campione (N. = 99) dal momento che la previsione poteva interessare solo le matricole che avevano sostenuto almeno un esame nel corso della precedente sessione estiva.

L’analisi della regressione multipla condotta utilizzando gli stessi predittori, mostra, con molte riserve dovute al ristretto numero di soggetti, che all’interno della funzione lineare individuata, il voto di diploma assume ancora una volta il maggior potere predittivo (ß = .33), seguito in subordine dal test nazionale (B = .27). Ai fini della predizione, i contributi della prova locale e dell’età risultano entrambi ininfluenti (Tab. 3.5).

Il quadrato del coefficiente di correlazione parziale (sr2) mette in risalto che il voto di diploma e il test nazionale forniscono entrambi un contributo unico alla predizione, risultato peraltro intuibile dalla mancanza di correlazione tra le due misure. I due predittori si confermano validi ad una successiva analisi stepwise in cui il divario tra i pesi standardizzati diminuisce ma la sostanziale differenza dei livelli di significatività statistica permane.

Nel complesso, entrambe le analisi sembrano confermare l’utilità predittiva del voto di diploma ed assegnare un minor peso – per lo più variabile in funzione del criterio – alla prova di ammissione. Delle due prove, quella nazionale e quella locale, la prima sembra fornire una migliore utilità predittiva, soprattutto se riferita alla media degli esami. Occorre tuttavia precisare che la predizione fornita dall’analisi della regressione, pur risultando statisticamente significativa (R = . 42; F4,94 = 5.02; p < .005), spiega una percentuale molto limitata della varianza del criterio: nell’ipotesi più ottimistica – in ogni caso limitata alla prima sessione utile di esami – l’85% della variabilità media dei voti riportati non è spiegabile dai predittori presi in considerazione.

© I predittori della performance accademica – Laura Foschi